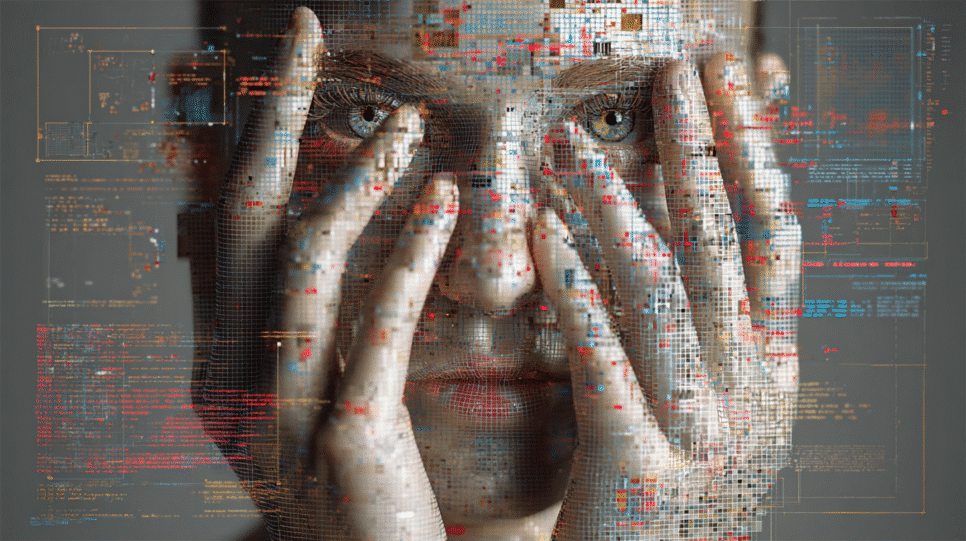

IA Generativa: Chatbots no Fluxo Crítico das Empresas

A rápida adoção de chatbots de IA generativa no atendimento ao cliente é um fenômeno global, impulsionado pela busca por automação, redução de custos e eficiência operacional. No entanto, essa integração crescente levanta preocupações sobre vulnerabilidades relacionadas à privacidade, governança e segurança digital.

Recentemente, uma investigação sobre a assistente Monica.AI destacou uma falha que expôs conversas, dados pessoais e tokens de usuários, evidenciando os riscos associados à implementação de tecnologias sem auditoria técnica adequada.

Governança Frágil e Risco de Vazamentos Inadvertidos

As soluções de IA disponíveis no mercado frequentemente operam com estruturas de armazenamento e telemetria que os usuários desconhecem. A falta de auditorias independentes e certificações de segurança contribui para um ambiente opaco, onde informações sensíveis podem ser mal geridas.

Testes em assistentes de IA revelaram problemas como políticas de privacidade vagas e a falta de criptografia adequada. No caso analisado, conversas eram armazenadas em texto simples, permitindo acesso não autorizado a dados confidenciais, além de tokens de sessão que poderiam ser explorados por invasores.

A Ilusão da Segurança Declarada em Políticas e Termos de Uso

Embora muitos assistentes de IA afirmem seguir práticas robustas de segurança, a discrepância entre o que é prometido e o que é realmente implementado é um desafio significativo. Políticas bem redigidas não garantem proteção efetiva, e testes técnicos frequentemente revelam vulnerabilidades.

Com mais de 1,2 bilhão de assistentes virtuais ativos globalmente, a ausência de auditorias obrigatórias representa um problema estrutural que pode comprometer a segurança dos usuários.

Riscos Crescentes para Empresas e Consumidores

Os riscos para as organizações vão além do vazamento de informações. A exposição acidental de dados sensíveis pode resultar em espionagem corporativa, chantagem digital e comprometimento de operações. À medida que as capacidades da IA aumentam, também cresce a vulnerabilidade a ataques de engenharia social.

Criminosos podem usar ferramentas de IA para manipular usuários e criar mensagens que parecem legítimas, aumentando a complexidade das fraudes.

Déficit de Auditoria e Certificações Públicas Aprofunda o Problema

Ainda não existe um mecanismo global padronizado para auditar assistentes generativos. Muitas empresas priorizam a velocidade de lançamento em detrimento da segurança, o que aumenta os riscos para os usuários.

A falta de certificações independentes e métricas técnicas universalizadas deixa os usuários à mercê da boa-fé dos fornecedores, o que pode resultar em consequências graves.

Orientações Práticas para Empresas e Usuários

Organizações devem implementar protocolos de governança para IA, estabelecendo diretrizes claras sobre o uso de dados. Recomenda-se evitar a inserção de informações confidenciais em sistemas não auditados e exigir validação técnica antes da adoção de assistentes.

Usuários individuais também devem adotar medidas de segurança, como autenticação de dois fatores e cautela ao compartilhar informações pessoais, para minimizar riscos.

A Confiança Automática Amplia Vulnerabilidades

Embora os chatbots de IA generativa representem um avanço significativo, é essencial que as empresas adotem práticas de segurança rigorosas. A automação não elimina os riscos, mas os transforma. Sem controles adequados e supervisão, a confiança automática pode se tornar uma ameaça tanto para empresas quanto para consumidores.

Fonte por: Its Show